robots.txt文件的写法和用法

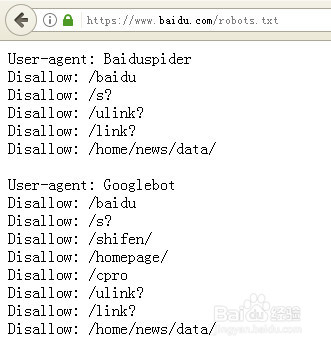

1、robots.txt文件,放在哪里?该文件必须放在网站的根目录中,如百度的

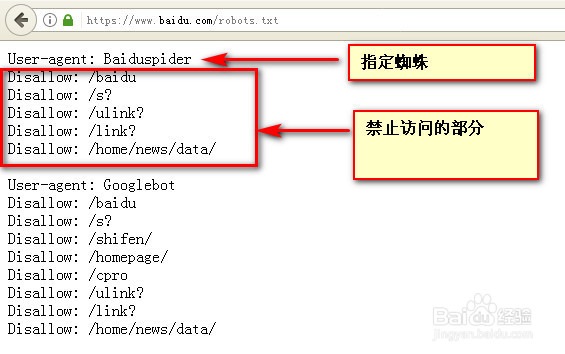

2、robots.txt的基本格式,首先指定一个蜘蛛爬虫,然后指定允许和禁止访问的部分,如:

# 指定一个蜘蛛爬虫

User-agent: Baiduspider

# 指定Baiduspider允许访问的目录

Allow: /access/

# 指定Baiduspider禁止访问的目录

Disallow: /admin/

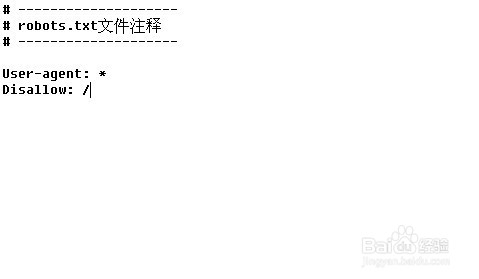

3、robots.txt的注释怎么写?注释的不是指令的一部分,主要作用是用于网站管理员的查看和阅读,注释以#号开始,如:

# 这一行是注释的部分

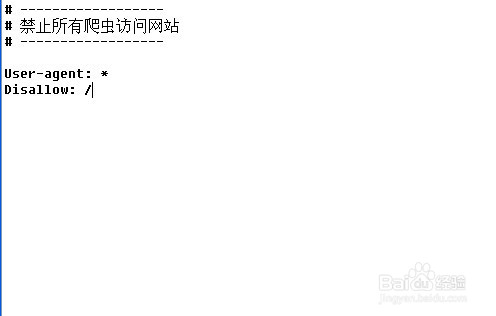

4、robots.txt文件怎么禁止蜘蛛爬虫的访问,Disallow是禁止访问的指令,如:

# 禁止所有爬虫访问网站

User-agent: *

Disallow: /

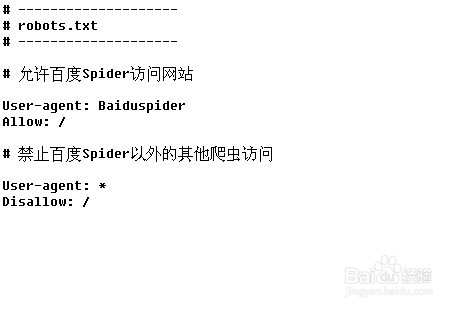

5、robots.txt文件怎么允许指定蜘蛛爬虫的可以访问,其他爬虫不可能访问,如:

# 允许百度Spider访问网站

User-agent: Baiduspider

Allow: /

# 禁止百度Spider以外的其他爬虫访问

User-agent: *

Disallow: /

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。

阅读量:108

阅读量:106

阅读量:52

阅读量:134

阅读量:186