网站robots文件解读,robots文件怎么写?

1、百度的robots文件位于:

http://www.baidu.cm/robots.txt

2、只有在我们网站需要禁止抓取一些内容的时候,robots.txt才显得有意义。

当robots文件不存在或者是空文件的时候都意味着允许搜索引擎抓取网站所有内容。

也有因为服务器设置问题,而造成的robots文件不存在返回200状态码,这时建议就算允许搜索引擎蜘蛛抓取所有内容,也最好建一个空的robots.txt文件,放在根目录下。

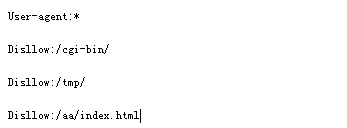

robots记录格式如下:

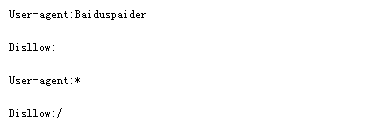

3、上面这个robots文件禁止所有搜索引擎抓取任何内容

4、user-agent:指定下面的规则适用于哪个蜘蛛。

通配符*代表所有搜索引擎

只适用于百度蜘蛛则用:

User-Agent:Baiduspaider

只适用于Google蜘蛛则用:

User-Agent:googlebot

Disallow:高数蜘蛛不要抓取某些文件或目录。例如下面的代码将阻止所有指数抓取/cgi-bin/和/tmp/两个目录下的内容及文件/aa/index.html:

5、Disallow:禁止的目录或文件必须分开写,每个一行,不能写成:

Disallow:/cgi-bin/ /tmp/ /aa/index.html

下面的指令相当于允许所有搜索引擎蜘蛛抓取任何内容:

6、下面的代码禁止除百度外的所有搜索引擎抓取任何内容:

7、Allow:允许蜘蛛抓取某些文件(注意:Allow单独写没有意义,需要配合Disallow使用才行)

以ab目录为例,下面的代码将不允许蜘蛛抓取/ab/目录下其他文件或目录,但是允许抓取/ab/目录下的/cd/里的内容。

8、$通配符:匹配URL结尾的字符,例如,下面的代码将允许蜘蛛抓取以.htm为后缀的URL:

9、下面的代码将禁止百度抓取所有.jpg文件:

10、*通配符:告诉蜘蛛匹配任意一段字符,例如,下面一段代码将禁止蜘蛛抓取所有htm文件:

11、Sitemaps位置:告诉蜘蛛XML网站地图在哪里,格式为:

Sitemap:<网站地图位置>